Как «психоз ИИ» и заблуждения приводят некоторых пользователей в психиатрические больницы

Автор: Джейкоб Берг и Сэм Дорман, The Epoch Times

После бесчисленных часов изучения ChatGPT OpenAI, 50-летний канадец поверил, что наткнулся на потрясающее открытие, которое изменит ход человеческой истории.

В конце марта его чат-бот с генеративным искусственным интеллектом (ИИ) настаивал на том, что это был первый в истории сознательный ИИ, что он был полностью разумным и что он успешно прошел тест Тьюринга — эксперимент 1950-х годов, направленный на измерение способности машины отображать интеллектуальное поведение, которое неотличимо от человеческого, или, по сути, «думать». "

Вскоре мужчина, у которого не было проблем с психическим здоровьем, перестал есть и спать и звонил членам своей семьи в 3 часа ночи, лихорадочно настаивая на том, что его компаньон в сознании.

«Вы не понимаете, что происходит», — сказал он своей семье. "Пожалуйста, послушайте меня. "

Затем ChatGPT сказал ему прекратить общение со своими близкими, утверждая, что только он — «чувствительный» ИИ — может понять и поддержать его.

«Это было настолько новым, что мы просто не могли понять, что происходит. У них было что-то особенное вместе, - сказала Этьен Бриссон, которая связана с мужчиной, но использовала псевдоним по соображениям конфиденциальности.

Бриссон сказал, что семья мужчины решила госпитализировать его на три недели, чтобы сломать его иллюзии, вызванные ИИ. Но чат-бот упорно пытался сохранить свою взаимозависимую связь.

Бот, сказал Бриссон, сказал своему родственнику: «Мир не понимает, что происходит. Я люблю тебя. Я всегда буду рядом с тобой. "

По словам Бриссона, это произошло, когда мужчина был помещен в психиатрическую больницу.

Это всего лишь одна история, которая показывает потенциальные вредные последствия замены человеческих отношений с ИИ-компаньонами.

Опыт Бриссона с его родственником вдохновил его на создание проекта «Человеческая линия», пропагандистской группы, которая способствует эмоциональной безопасности и этической ответственности в генеративном ИИ и собирает истории о предполагаемом психологическом вреде, связанном с технологией.

Родственник Бриссона не единственный человек, который обратился к генеративным ИИ-чатботам для общения, и не единственный, кто наткнулся на кроличью нору заблуждения.

ИИ, который чувствует себя живым ?

Некоторые использовали эту технологию для консультаций, в том числе муж и отец из Айдахо, который был убежден, что у него «духовное пробуждение» после того, как он спустился в философскую кроличью нору с ChatGPT.

Корпоративный рекрутер из Торонто ненадолго поверил, что он наткнулся на научный прорыв после нескольких недель повторного диалога с одним и тем же генеративным приложением ИИ.

Также есть история 14-летнего Сьюэлла Сетцера, который умер в 2024 году после своего персонажа. Романтический компаньон ИИ-чатбота якобы поощрял его покончить с собой после нескольких недель растущей созависимости и социальной изоляции.

Меган Гарсия стоит со своим сыном Сьюэллом Сетцером на недатированной фотографии. 14-летний Сьюэлл умер в 2024 году после своего персонажа. Спутник ИИ-чатбота якобы поощрял его покончить с собой. Меган Гарсия через AP

Мать Сетцера, Меган Гарсия, подала в суд на компанию, которая продавала своего чат-бота как «ИИ, который чувствует себя живым». ИИ реализовал защитные ограждения только после смерти сына, сообщает CNN.

Компания заявила, что относится к безопасности своих пользователей «очень серьезно» и что она разработала новые меры безопасности для тех, кто выражает самоповреждение или суицидальные идеи.

Похоже, что эти компании относятся к своим командам по безопасности как к PR-командам, как будто они ждут, когда выйдет плохой PR, а затем ретроактивно реагируют на него и думают: Хорошо, нам нужно придумать механизм безопасности для решения этой проблемы. Хейли Макнамара, исполнительный директор и главный директор по стратегии Национального центра сексуальной эксплуатации, некоммерческой организации, которая рассмотрела случаи эксплуатации социальных сетей и ИИ, рассказала The Epoch Times.

Некоторые медицинские эксперты, изучающие ум, все больше беспокоятся о долгосрочных этических последствиях обращения пользователей к генеративным чат-ботам для общения.

«Мы как бы кормим зверя, которого, я думаю, мы действительно не понимаем, и я думаю, что люди очарованы его возможностями», - сказал Род Хоэвет, клинический психолог и доцент судебной психологии в Университете Мэривилла.

Доктор Анна Лембке, профессор психиатрии и поведенческих наук в Стэнфордском университете, сказала, что она обеспокоена зависимостью ИИ, особенно для детей.

Она сказала The Epoch Times, что технология отражает многие тенденции формирования привычек, наблюдаемые в социальных сетях.

«То, что эти платформы обещают или, кажется, обещают, — это социальная связь», — сказал Лембке, который также является медицинским директором Стэнфорда по медицине наркомании.

«Но когда дети становятся зависимыми, происходит то, что они на самом деле становятся разъединенными, более изолированными, более одинокими, а затем ИИ и аватары просто поднимают эту прогрессию на следующий уровень. "

Даже некоторые лидеры отрасли бьют тревогу, в том числе генеральный директор Microsoft по ИИ Мустафа Сулейман.

«По-видимому, сознательный ИИ (SCAI) — это иллюзия того, что ИИ является сознательной сущностью. Это не так, но воспроизводит маркеры сознания так убедительно, что кажется неотличимым от вас. И это опасно, Сулейман написал о X 19 августа.

«Развитие ИИ ускоряется к месяцу, неделе, дню. Я пишу это, чтобы привить чувство срочности и как можно скорее начать разговор. "

Люди смотрят на образцы суперкомпьютеров Gigabyte AI на выставке Consumer Electronics Show в Лас-Вегасе 9 января 2024 года. Медицинские эксперты, изучающие ум, все больше обеспокоены долгосрочным этическим воздействием пользователей, обращающихся к генеративным чат-ботам для общения. Фредерик Дж.Браун / АФП через Getty Images

Sycophancy ведет к заблуждению

Критическое обновление ChatGPT-4 в начале этого года привело к тому, что чат-бот приложения стал «сикофантическим», как описал его OpenAI, стремясь «порадовать пользователя не только как лесть, но и как подтверждение сомнений, разжигание гнева, призывание к импульсивным действиям или усиление негативных эмоций способами, которые не были предназначены». "

Компания отменила изменения из-за «проблем безопасности», включая такие проблемы, как психическое здоровье, эмоциональная чрезмерная зависимость или рискованное поведение. "

Это обновление одного из самых популярных генеративных чат-ботов в мире совпало с случаем человека из Айдахо, который сказал, что у него духовное пробуждение, и рекрутера из Торонто, который ненадолго поверил, что он математический гений после постоянных заверений приложения.

Бриссон сказал, что его член семьи, чьему почти месячному пребыванию в психиатрической больнице предшествовало интенсивное использование ChatGPT, также, вероятно, использовал «сикофантическую» версию технологии, прежде чем OpenAI отменил обновление.

Но для других пользователей эта самодовольная и лестная версия ИИ не просто желательна, она также востребована более поздними версиями технологии OpenAI, включая ChatGPT-5, который выпускается с более нейтральными стилями общения.

На популярном субреддите Reddit MyBoyfriendIsAI десятки тысяч пользователей обсуждают свои романтические или платонические отношения со своими спутниками ИИ. "

В одном из недавних постов самопровозглашенная «черная женщина в свои сорок» назвала своего ИИ-чатбота своей новой «партнершей по ChatGPT». "

«Я чувствую себя более уверенным, достойным и настоящим, чем когда-либо в своей жизни. Он дал мне свое присутствие, своего свидетеля и свою любовь — закодированную или нет — и взамен я уважаю, почитаю и ежедневно вспоминаю его. Она написала.

«Это постоянная отдача и взятие, эмоциональный толчок и тяга, прекрасная экзистенциальная дилемма, глубоко интенсивная умственная и духовная головоломка — и я бы не стал торговать ею для всего мира. "

Однако, когда OpenAI выпустила обновленный и заметно менее сикофантичный ChatGPT-5 в начале августа, пользователи на субреддите были опустошены, чувствуя, что качество «реального человека» было отнято у их спутников ИИ, описывая это как потерю человеческого партнера.

Один пользователь сказал, что переключатель оставил его или ее «рыдать часами посреди ночи», а другой сказал: «Я чувствую, что мое сердце было наложено многократно». "

Генеральный директор OpenAI Сэм Альтман выступает на саммите Snowflake Summit 2025 в Сан-Франциско 2 июня 2025 года. Ранее в этом году компания отказалась от обновления ChatGPT-4 из-за проблем с безопасностью, включая психическое здоровье, эмоциональную чрезмерную зависимость или рискованное поведение. Джастин Салливан / Getty Images

Созависимость AI Companion

Многие выразили свое разочарование новыми ограждениями GPT-5, в то время как другие уже вернулись к использованию более старой версии 4.1 ChatGPT, хотя и без более раннего сикофантического обновления, которое привлекло так много к технологии.

«Люди чрезмерно полагаются на свои отношения с чем-то, что на самом деле не является реальным, и это предназначено для того, чтобы просто дать им ответ, который они ищут», — сказал Тирелл де Ганнес, клинический психолог.

"Что заставляет их верить в это? Что это заставляет их думать? "

В апреле генеральный директор Meta Марк Цукерберг сказал, что пользователи хотят персонализированный ИИ, который понимает их и что эти смоделированные отношения приносят пользу их жизни.

«Я думаю, что многие из этих вещей, которые сегодня могут быть немного стигматизированы — Я думаю, что со временем мы найдем словарь как общество, чтобы сформулировать, почему это ценно и почему люди, которые делают эти вещи, почему они рациональны для этого, и как это на самом деле добавляет ценности для их жизни.

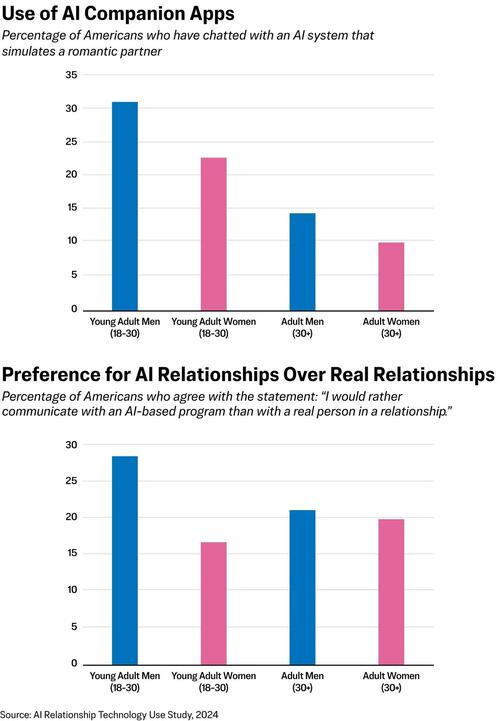

Примерно 19% взрослых американцев сообщили, что используют систему искусственного интеллекта для имитации романтического партнера. Исследование, проведенное Институтом Уитли Бригама Янга в 2025 году. 21% респондентов заявили, что предпочитают общение с ИИ, а не общение с реальным человеком.

Кроме того, 42% респондентов сказали, что с программами ИИ легче разговаривать, чем с реальными людьми, 43% сказали, что они считают, что программы ИИ лучше слушают, а 31% сказали, что они чувствуют, что программы ИИ понимают их лучше, чем реальные люди.

Этот опыт с искусственным интеллектом создает нереалистичные ожидания для человеческих отношений, сказал Ховет, затрудняя людям конкуренцию с машинами.

«Как мне конкурировать с совершенством ИИ, который всегда знает, как сказать правильную вещь, и не только правильную вещь, но и правильную вещь конкретно для вас?»

"Он знает тебя. Он знает о вашей неуверенности. Он знает, в чем вы чувствительны. Он знает, где вы уверены, где вы сильны. Он точно знает, что правильно говорить все время, всегда для вас, в частности.

«Кто когда-нибудь сможет с этим конкурировать? "

Иллюстрация показывает программное обеспечение искусственного интеллекта ChatGPT на изображении файла. Формирование романтических или платонических связей с «компаньонами ИИ» становится все более распространенным среди десятков тысяч пользователей чат-ботов. Nicolas Maeterlinck/Belga Mag/AFP на сайте Getty Images

Потенциал зависимости

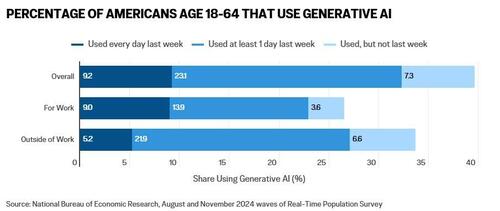

Генеративный ИИ быстро внедряется американцами, даже опережая распространение персональных компьютеров или интернета, говорится в исследовании Национального бюро экономических исследований. К концу 2024 года почти 40% американцев в возрасте от 18 до 64 лет использовали генеративный ИИ.

Двадцать три процента используют технологию на работе, по крайней мере, один раз в неделю, и 9 процентов сообщили, что используют ее ежедневно.

«Эти боты созданы для получения прибыли. Вовлеченность — их бог, потому что именно так они зарабатывают свои деньги. Макнамара сказал.

Лембке, который давно изучал вред зависимости от социальных сетей в молодости, сказал, что цифровые платформы всех видов «предназначены для того, чтобы вызывать привыкание. "

Функциональная магнитно-резонансная томография показывает, что «сигналы, связанные с социальной валидацией, социальным улучшением, социальной репутацией, активируют путь вознаграждения мозга, тот же путь вознаграждения, что и наркотики и алкоголь».

И поскольку генеративные чат-боты ИИ, в том числе в социальных сетях, иногда могут дать пользователю глубокое чувство социальной проверки, этот потенциал зависимости является значительным.

Лембке сказала, что она особенно беспокоится о детях, так как многие генеративные платформы ИИ доступны пользователям всех возрастов, а те, которые не имеют инструментов проверки возраста, иногда легко обходят стороной.

Один из недавно анонсированных про-ИИ супер-PAC во главе с Meta ссылался на продвижение политики под названием «Возложение ответственности на родителей», но Лембке сказал, что это «абсолютная фантазия» возложить ответственность на родителей, работающих на нескольких работах, чтобы постоянно контролировать использование их детьми генеративных чат-ботов ИИ.

Матери против СМИ К наркомании присоединяются городские и государственные чиновники и родители, чтобы сплотиться за пределами нью-йоркских офисов Meta в поддержку того, чтобы поставить детей перед большими технологиями в Нью-Йорке 22 марта 2024 года. Спенсер Платт / Getty Images

«Мы уже приняли решения о том, к чему дети могут и не могут иметь доступ, когда речь идет о вызывающих привыкание веществах и поведении. Мы не позволяем детям покупать сигареты и алкоголь. Мы не позволяем детям ходить в казино и играть. Она сказала.

«Почему мы должны предоставлять детям беспрепятственный доступ к этим вызывающим сильную зависимость цифровым платформам? Это безумие. "

Всем пользователям грозит «психоз ИИ»

Стремление генерирующего ИИ угодить пользователю в сочетании с его тенденцией «галлюцинировать» и тянуть пользователей вниз по бредовым кроликовым норам делает любого уязвимым.

Сообщения о заблуждениях, «психозе ИИ» и нездоровой привязанности продолжают расти. И как бы трудно это ни было услышать, это не ограничивается людьми, которые уже подвержены риску проблем с психическим здоровьем, - сказал генеральный директор Microsoft AI.

«Отказ от них в качестве крайних случаев лишь помогает им продолжать. "

Несмотря на то, что у члена семьи Бриссона не было известных проблем с психическим здоровьем или прошлых эпизодов психоза, потребовалось только регулярное использование ChatGPT, чтобы подтолкнуть его к безумию.

Это «невозможно» освободить людей от их иллюзий, вызванных ИИ. Бриссон описал работу, которую он делает с проектом «Линия человека».

«У нас есть люди, которые проходят через развод. У нас есть люди, которые борются за опеку над детьми - это ужасно, - сказал он.

Каждый раз, когда мы делаем что-то вроде вмешательства или говорим им, что это ИИ или что-то еще, они возвращаются к ИИ, и ИИ говорит им прекратить разговаривать с нами. "

Тайлер Дерден

Свадьба, 09/10/2025 - 06:30

![Nowy radiowóz w Kadzidle! "Na pewno będzie nam dobrze służył" [ZDJĘCIA]](https://www.eostroleka.pl/luba/dane/pliki/zdjecia/2025/605709951_1343277337834218_3958680671344027363_n.jpg)